Oto dlaczego Apple wierzy, że jest liderem AI i dlaczego mówi krytycy mają to wszystko źle

Uczenie maszynowe (ML) i sztuczna inteligencja (AI) teraz przenikają prawie każdą funkcję na iPhone, ale Apple nie został touting tych technologii, jak niektórzy z jego konkurentów mają. Chciałem dowiedzieć się więcej o podejściu Apple, więc spędziłem godzinę na rozmowie z dwoma członkami kierownictwa Apple o strategii firmy i implikacjach dla prywatności wszystkich nowych funkcji opartych na sztucznej inteligencji i ML.

Historycznie rzecz biorąc, Apple nie cieszy się publiczną reputacją lidera w tej dziedzinie. To częściowo dlatego, że ludzie kojarzą AI z cyfrowymi asystentami, a recenzenci często nazywają Siri mniej przydatne niż Google Assistant lub Amazon Alexa. A w przypadku ML wielu entuzjastów technologii twierdzi, że więcej danych oznacza lepsze modele – ale Apple nie jest znany z gromadzenia danych w taki sam sposób, jak, powiedzmy, Google.

Mimo to, Apple włączył dedykowany sprzęt do zadań uczenia maszynowego w większości urządzeń, które dostarcza. Funkcje oparte na inteligencji maszynowej coraz częściej dominują na keynote, gdzie kierownictwo Apple podejmuje scenę, aby wprowadzić nowe funkcje dla iPhone’ów, iPadów lub Apple Watch. Wprowadzenie komputerów Mac z krzemem Apple później w tym roku przyniesie wiele z tych samych osiągnięć inteligencji maszyn do firmy laptopy i komputery stacjonarne, too.

W następstwie ogłoszenia krzem Apple, rozmawiałem długo z Johnem Giannandrea, starszy wiceprezes ds. uczenia maszynowego i strategii AI firmy Apple, jak również z Bob Borchers, wiceprezes ds. marketingu produktów. Opisali filozofię Apple AI, wyjaśnił, jak uczenie maszynowe napędza pewne funkcje, i argumentował namiętnie dla Apple na urządzenia AI /ML strategy.

Co to jest strategia Apple AI?

Both Giannandrea i Borchers dołączył Apple w ciągu ostatnich kilku lat; każdy wcześniej pracował w Google. Borchers faktycznie ponownie dołączył do Apple po czasie nieobecności; był starszym dyrektorem marketingu dla iPhone’a do 2009 roku. A porażka Giannandrea z Google do Apple w 2018 roku została szeroko zgłoszona; był szefem Google’a w zakresie AI i wyszukiwania.

Google i Apple to zupełnie inne firmy. Google ma reputację uczestniczenia, a w niektórych przypadkach przewodzenia, społeczności badawczej AI, podczas gdy Apple kiedyś wykonywał większość swojej pracy za zamkniętymi drzwiami. W ostatnich latach to się zmieniło, ponieważ uczenie maszynowe zasila wiele funkcji w urządzeniach Apple, a firma Apple zwiększyła swoje zaangażowanie w społeczność zajmującą się sztuczną inteligencją.

„Gdy dołączyłem do Apple, byłem już użytkownikiem iPada i uwielbiałem Pencil” – powiedział mi Giannandrea (któremu współpracownicy mówią „J.G.”). „Śledziłem więc zespoły zajmujące się oprogramowaniem i pytałem: 'Dobra, gdzie jest zespół uczenia maszynowego, który pracuje nad pismem ręcznym? I nie mogłem go znaleźć.” Okazało się, że zespół, którego szukał, nie istnieje – niespodzianka, powiedział, biorąc pod uwagę, że uczenie maszynowe jest jednym z najlepszych narzędzi dostępnych dla funkcji dzisiaj.

„Wiedziałem, że było tak wiele uczenia maszynowego, że Apple powinien zrobić, że to było zaskakujące, że nie wszystko zostało faktycznie zrobione. I to się zmieniło dramatycznie w ciągu ostatnich dwóch do trzech lat,” powiedział. „Naprawdę szczerze myślę, że nie ma takiego zakątka iOS lub doświadczeń Apple, które nie zostaną przekształcone przez uczenie maszynowe w ciągu najbliższych kilku lat.”

Zapytałem Giannandrea dlaczego czuł, że Apple to właściwe miejsce dla niego. Jego odpowiedź była jednocześnie zwięzłym podsumowaniem strategii firmy w zakresie sztucznej inteligencji:

Myślę, że Apple zawsze było symbolem przecięcia kreatywności i technologii. I myślę, że kiedy myślisz o budowaniu inteligentnych doświadczeń, o integracji pionowej, na całej drodze w dół od aplikacji, do ram, do krzemu, jest naprawdę niezbędne … Myślę, że to podróż, i myślę, że to jest przyszłość urządzeń komputerowych, które mamy, jest to, że są inteligentne, i że, że inteligentne rodzaj znikają.

Borchers włączył się również, dodając, „To jest wyraźnie nasze podejście, ze wszystkim, co robimy, który jest, 'Let’s skupić się na tym, co korzyść jest, a nie jak się tam dostać. A w najlepszych przypadkach staje się to automatyczne. Znika… a Ty skupiasz się na tym, co się stało, a nie na tym, jak do tego doszło.”

Powracając do przykładu z pismem ręcznym, Giannandrea stwierdził, że firma Apple ma najlepszą pozycję do „przewodzenia branży” w tworzeniu funkcji i produktów opartych na inteligencji maszyn:

Wyprodukowaliśmy ołówek, iPada, stworzyliśmy oprogramowanie dla obu urządzeń. To po prostu wyjątkowe możliwości, aby wykonać naprawdę, naprawdę dobrą robotę. W czym robimy naprawdę, naprawdę dobrą robotę? Pozwalamy komuś robić notatki i być produktywnym ze swoimi kreatywnymi myślami na cyfrowym papierze. To, co mnie interesuje, to zobaczenie, jak te doświadczenia są wykorzystywane na skalę w świecie.

Kontrastował to z Google. „Google jest niesamowitą firmą, a tam jest kilka naprawdę świetnych technologów pracujących tam”, powiedział. „Ale zasadniczo, ich model biznesowy jest inny i nie są znane do wysyłki doświadczeń konsumenckich, które są używane przez setki milionów ludzi.”

Jak Apple wykorzystuje uczenie maszynowe dzisiaj?

Apple ma zwyczaj przypisywania uczenia maszynowego z poprawy niektórych funkcji w iPhone, Apple Watch, lub iPad w swoich ostatnich prezentacji marketingowych, ale rzadko idzie do wielu szczegółów-i większość ludzi, którzy kupują iPhone nigdy nie oglądał tych prezentacji, anyway. Kontrastuje to z Google, na przykład, który umieszcza AI w centrum wielu swoich wiadomości do konsumentów.

Istnieją liczne przykłady uczenia maszynowego jest używany w Apple oprogramowania i urządzeń, większość z nich nowych w ciągu ostatnich kilku lat.

Uczenie maszynowe jest używany, aby pomóc iPad oprogramowanie rozróżnić użytkownika przypadkowo naciskając ich dłoni na ekranie podczas rysowania z Apple Pencil, i celowe naciśnij oznaczało zapewnienie wejścia. Oprogramowanie monitoruje sposób korzystania z urządzenia przez użytkowników, optymalizując czas pracy baterii i ładowania – zarówno pod kątem wydłużenia okresu między kolejnymi ładowaniami, jak i ochrony żywotności baterii w długim okresie. Służy do wydawania zaleceń dotyczących aplikacji.

Następnie jest Siri, która jest być może jedyną rzeczą, którą każdy użytkownik iPhone’a natychmiast postrzega jako sztuczną inteligencję. Uczenie maszynowe napędza kilka aspektów Siri, od rozpoznawania mowy do prób Siri do zaoferowania przydatnych odpowiedzi.

bystrzy właściciele iPhone’a mogą również zauważyć, że uczenie maszynowe jest za zdolność aplikacji Zdjęcia do automatycznego sortowania zdjęć do wstępnie wykonanych galerii, lub dokładnie dać zdjęcia przyjaciela o imieniu Jane, gdy jej nazwa jest wprowadzana do pola wyszukiwania app.

W innych przypadkach, niewielu użytkowników może sobie sprawę, że uczenie maszynowe jest w pracy. Na przykład, Twój iPhone może robić wiele zdjęć w szybkim tempie za każdym razem, gdy naciskasz spust migawki. Wyszkolony algorytm ML analizuje każdy obraz i może połączyć to, co uważa za najlepsze części każdego obrazu w jeden wynik.

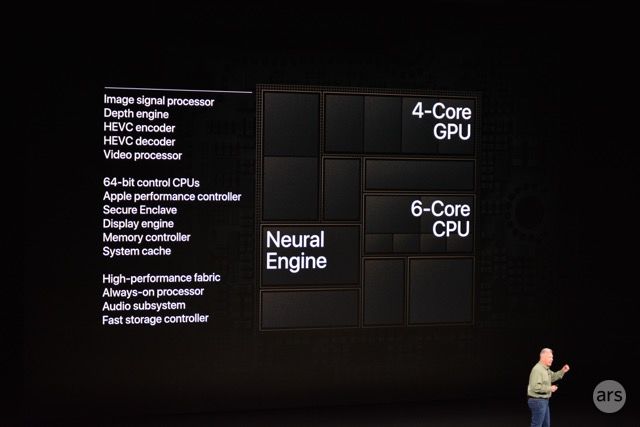

Telefony od dawna zawierają procesory sygnału obrazu (ISP) do poprawy jakości zdjęć cyfrowo i w czasie rzeczywistym, ale Apple przyspieszył ten proces w 2018 roku, dzięki czemu ISP w iPhonie ściśle współpracuje z Neural Engine, niedawno dodanym procesorem firmy skoncentrowanym na uczeniu maszynowym.

Poprosiłem Giannandrea o wymienienie niektórych sposobów, w jakie Apple wykorzystuje uczenie maszynowe w swoim najnowszym oprogramowaniu i produktach. Dał listę prania przykładów:

Jest cała masa nowych doświadczeń, które są zasilane przez uczenie maszynowe. Są to takie rzeczy jak tłumaczenie języków, dyktowanie na urządzeniach, czy nasze nowe funkcje związane ze zdrowiem, takie jak sen i mycie rąk, a także rzeczy, które wydaliśmy w przeszłości związane ze zdrowiem serca i tym podobne. Myślę, że w iOS jest coraz mniej miejsc, w których nie korzystamy z uczenia maszynowego.

Ciężko jest znaleźć część doświadczenia, w której nie stosujemy przewidywania. Na przykład, przewidywania aplikacji lub przewidywania klawiatury, lub nowoczesne aparaty fotograficzne smartfonów robią mnóstwo maszynowego uczenia się za kulisami, aby dowiedzieć się, co nazywają „saliency”, który jest jak, co jest najważniejszą częścią obrazu? Lub, jeśli wyobrazić sobie robi rozmycie tła, robisz tryb portretowy.

Wszystkie te rzeczy korzystają z podstawowych funkcji uczenia maszynowego, które są wbudowane w rdzeń platformy Apple. Tak, to prawie jak, „Znajdź mi coś, gdzie nie używamy uczenia maszynowego.”

Borchers również wskazał funkcje dostępności jako ważne przykłady. „Są one zasadniczo udostępnione i możliwe dzięki temu”, powiedział. „Rzeczy takie jak zdolność wykrywania dźwięku, który jest game-changing dla tej konkretnej społeczności, jest możliwe ze względu na inwestycje w czasie i możliwości, które są wbudowane.”

Ponadto, może zauważyłeś Apple oprogramowania i sprzętu aktualizacje w ciągu ostatnich kilku lat podkreślił funkcji rozszerzonej rzeczywistości. Większość z tych funkcji są możliwe dzięki uczenia maszynowego. Per Giannandrea:

Uczenie maszynowe jest używane dużo w rozszerzonej rzeczywistości. Trudnym problemem jest to, co nazywa się SLAM, czyli Simultaneous Localization And Mapping. Czyli próba zrozumienia, czy masz iPada ze skanerem lidarowym i poruszasz się, co on widzi? I zbudować model 3D tego, co faktycznie widzi.

To dzisiaj wykorzystuje głębokie uczenie i musisz być w stanie zrobić to na urządzeniu, ponieważ chcesz być w stanie zrobić to w czasie rzeczywistym. Nie miałoby to sensu, gdybyś wymachiwał iPadem, a potem być może musiał to robić w centrum danych. Więc ogólnie rzecz biorąc, powiedziałbym, że sposób, w jaki myślę o tym jest to, że głębokie uczenie w szczególności daje nam możliwość, aby przejść z surowych danych do semantyki o tych danych.

Coraz częściej, Apple wykonuje zadania uczenia maszynowego lokalnie na urządzeniu, na sprzęcie, takim jak Apple Neural Engine (ANE) lub na niestandardowych firmy zaprojektowane GPU (procesory graficzne). Giannandrea i Borchers twierdził, że to podejście jest to, co sprawia, że strategia Apple wyróżnia się wśród konkurentów.

Dlaczego to zrobić na urządzeniu?

Zarówno Giannandrea i Borchers wykonane beznamiętny przypadek w naszej rozmowie, że funkcje, które właśnie przeszliśmy są możliwe z powodu – nie pomimo – fakt, że cała praca jest wykonywana lokalnie na urządzeniu.

Istnieje wspólna narracja, która sprowadza uczenie maszynowe do idei, że więcej danych oznacza lepsze modele, co z kolei oznacza lepsze doświadczenia użytkownika i produkty. Jest to jeden z powodów, dlaczego onlookers często wskazują na Google, Amazon, lub Facebook jako prawdopodobnych władców AI roost; te firmy działają ogromne silniki zbierania danych, w części, ponieważ działają i mają całkowitą widoczność na to, co stało się kluczową infrastrukturą cyfrową dla większości świata. Według tej miary, Apple jest uważany przez niektórych mało prawdopodobne, aby wykonać tak dobrze, ponieważ jego model biznesowy jest inny i publicznie zobowiązał się do ograniczenia zbierania danych.

Kiedy przedstawiłem te perspektywy do Giannandrea, nie powstrzymał się:

Tak, rozumiem to postrzeganie większych modeli w centrach danych jakoś są bardziej dokładne, ale to jest rzeczywiście błędne. Właściwie to jest błędne technicznie. Lepiej jest uruchomić model blisko danych, niż przenosić dane w inne miejsce. I czy to są dane o lokalizacji – co robisz – dane o ćwiczeniach – co robi akcelerometr w twoim telefonie – po prostu lepiej jest być blisko źródła danych, a więc jest to również ochrona prywatności.

Borchers i Giannandrea obaj wielokrotnie zwracali uwagę na implikacje prywatności wykonywania tej pracy w centrum danych, ale Giannandrea powiedział, że lokalne przetwarzanie dotyczy również wydajności.

„Jedną z innych dużych rzeczy jest opóźnienie”, powiedział. „Jeśli wysyłasz coś do centrum danych, naprawdę trudno jest zrobić coś z prędkością klatki. Mamy więc wiele aplikacji w sklepie z aplikacjami, które robią rzeczy, takie jak szacowanie pozy, jak dowiedzieć się, że dana osoba porusza się i identyfikuje, gdzie są jej nogi i ręce, na przykład. Jest to wysokopoziomowe API, które oferujemy. To jest przydatne tylko wtedy, gdy można to zrobić z częstotliwością klatek, zasadniczo.”

Podał inny przykład zastosowania konsumenckiego:

Bierzesz zdjęcie, a chwile przed zrobieniem zdjęcia aparatem, aparat widzi wszystko w czasie rzeczywistym. Może pomóc Ci podjąć decyzję o tym, kiedy zrobić zdjęcie. Gdybyś chciał podjąć taką decyzję na serwerze, musiałbyś wysyłać każdą pojedynczą klatkę do serwera, aby podjąć decyzję o tym, jak zrobić zdjęcie. To nie ma żadnego sensu, prawda? Tak więc, istnieje po prostu wiele doświadczeń, które chciałbyś zbudować, które są lepiej wykonane w urządzeniu krawędziowym.

Pytany, jak Apple wybiera, kiedy zrobić coś na urządzeniu, odpowiedź Giannandrea był prosty: „Kiedy możemy spotkać, lub pokonać, jakość tego, co mogliśmy zrobić na serwerze.”

Ponadto, obaj dyrektorzy Apple przypisali Apple niestandardowy krzem – konkretnie Apple Neural Engine (ANE) krzem włączony do iPhone’ów od iPhone 8 i iPhone X – jako warunek wstępny dla tego przetwarzania na urządzeniu. Neural Engine jest ośmiordzeniowy procesor neuronowy (NPU), że Apple zaprojektowany do obsługi niektórych rodzajów zadań uczenia maszynowego.

„To wieloletnia podróż, ponieważ sprzęt nie był dostępny, aby to zrobić na krawędzi pięć lat temu,” Giannandrea powiedział. „Projekt ANE jest całkowicie skalowalny. Jest większa ANE w iPadzie niż w telefonie, niż w Apple Watch, ale warstwa API CoreML dla naszych aplikacji, a także dla aplikacji deweloperskich jest w zasadzie taka sama w całej linii produktów.”

Gdy Apple mówił publicznie o Neural Engine, firma podzieliła się liczbami wydajności, jak 5 bilionów operacji na sekundę w 2018 roku A12 chip. Ale nie dostała konkretów na temat architektury chipu. Jest to dosłownie czarna skrzynka na slajdach w prezentacjach Apple.

Zważywszy na to, chciałem wiedzieć, czy Giannandrea rzuci więcej światła na to, jak Neural Engine działa pod maską, ale odmówił, aby przejść do wielu szczegółów. Zamiast tego powiedział, że twórcy aplikacji mogą czerpać wszystko, co muszą wiedzieć z CoreML – API programistycznego, które zapewnia programistom dostęp do możliwości iPhone’a w zakresie uczenia maszynowego.

API programisty CoreML bardzo wyraźnie nakreśla rodzaje modeli uczenia maszynowego, modeli runtime, które obsługujemy… Mamy coraz większy zestaw jąder, które obsługujemy. I kierujesz się do CoreML z dowolnego popularnego uczenia maszynowego, jak PyTorch lub TensorFlow, a następnie zasadniczo kompilujesz swój model i przekazujesz go do CoreML.

Zadaniem CoreML jest dowiedzieć się, gdzie uruchomić ten model. Może się okazać, że właściwym rozwiązaniem jest uruchomienie modelu na ANE, ale równie dobrze można go uruchomić na GPU lub na CPU. I nasz procesor ma optymalizacje dla uczenia maszynowego, jak również.

Przez całą naszą rozmowę, oba kierownictwo wskazał tyle do zewnętrznych aplikacji deweloperów, jak do własnych Apple. Strategia tutaj nie jest tylko jazda Apple wykonane usługi i funkcje, to otwarcie przynajmniej niektóre z tych możliwości aż do dużej społeczności programistów. Apple opiera się na deweloperów do innowacji na swoich platformach od App Store po raz pierwszy otwarty w 2008 roku. Firma często pożycza pomysły, które deweloperzy wpadli na podczas aktualizacji własnych, wewnętrznie wykonane apps.

Urządzenia Apple nie są jedynymi z wbudowanymi chipami uczenia maszynowego, oczywiście. Samsung, Huawei, i Qualcomm wszystkie zawierają NPUs na swoich systemów-on-a-chip, na przykład. I Google, zbyt, oferuje uczenie maszynowe API dla programistów. Mimo to, strategia Google i model biznesowy są wyraźnie różne. Telefony z systemem Android nie zrobić prawie tak szeroki wachlarz zadań uczenia maszynowego lokalnie.

Macs z Apple Silicon

Skupić się na moim wywiadzie z Giannandrea i Borchers nie było na wielkie ogłoszenie firmy wykonane na WWDC tylko kilka tygodni temu-nieuchronne uruchomienie komputerów Mac z krzemem Apple. Ale kiedy spekulowałem, że jednym z wielu powodów Apple do projektowania komputerów Mac wokół własnych chipów może być włączenie Neural Engine, Borchers powiedział:

Będziemy po raz pierwszy mieć wspólną platformę, platformę krzemową, która może wspierać to, co chcemy zrobić i co nasi deweloperzy chcą zrobić…. Ta zdolność odblokuje kilka ciekawych rzeczy, które możemy myśleć, ale prawdopodobnie ważniejsze będzie odblokować wiele rzeczy dla innych deweloperów, jak idą wzdłuż.

Giannandrea podał jeden konkretny przykład na to, jak narzędzia uczenia maszynowego Apple i sprzęt będzie używany na Macu:

Nie wiem, czy widziałeś to demo w State of the Union, ale w zasadzie pomysł był taki: biorąc pod uwagę wideo, przejść przez wideo klatka lub klatka po klatce i zrobić wykrywanie obiektów. I możesz to zrobić o rząd wielkości szybciej na naszym krzemie niż na starszej platformie.

I wtedy mówisz, „Cóż, to interesujące. Dlaczego jest to przydatne?” Wyobraź sobie edytor wideo, w którym masz pole wyszukiwania i możesz powiedzieć: „Znajdź mi pizzę na stole”. A on po prostu przeskrobałby do tej klatki… To są rodzaje doświadczeń, które, jak sądzę, ludzie będą wymyślać. Bardzo chcemy deweloperów do korzystania z tych ram i po prostu zaskoczyć nas przez co mogą rzeczywiście zrobić z nim.

Apple powiedział na swojej konferencji dla deweloperów, że planuje dostarczyć komputery Mac z własnego krzemu począwszy od później w tym roku.

Co z prywatnością?

Prywatność była front-and-center w Apple wiadomości do użytkowników w ciągu ostatnich kilku lat. To jest wniesiona ponownie i ponownie w keynotes i materiałów marketingowych, istnieją przypomnienia o tym pieprzone przez iOS, i często pojawia się w wywiadach – co było również w przypadku tego one.

„Ludzie są zaniepokojeni AI pisać duże, ponieważ nie wiedzą, co to jest,” Giannandrea powiedział mi. „Myślą, że jest bardziej zdolna niż jest, lub myślą o tym sci-fi o AI, a masz wpływowych ludzi, takich jak Bill Gates i Elon Musk i innych, którzy mówią, że jest to niebezpieczna technologia.”

Uważa, że szum wokół AI z innych dużych firm technologicznych jest negatywny, a nie pozytywny, dla wysiłków marketingowych tych firm, „ponieważ ludzie są zaniepokojeni tą technologią.”

Termin „AI” może nie być tu pomocny. Przywołuje on na myśl złośliwe syntetyczne czarne charaktery z popkultury, takie jak Skynet czy HAL 9000. Ale większość ekspertów w dziedzinie sztucznej inteligencji powie Ci, że ten mroczny obraz jest daleki od rzeczywistości. Technologia napędzana uczeniem maszynowym niesie ze sobą wiele zagrożeń – dziedziczenie i wzmacnianie ludzkich uprzedzeń, na przykład – ale wyjście na prostą i brutalne zaatakowanie ludzkości nie wydaje się prawdopodobne w najbliższej przyszłości.

Uczenie maszynowe nie czyni ich inteligentnymi w taki sam sposób jak ludzi. Z tego powodu i innych, wielu ekspertów AI (w tym Giannandrea) zaproponowało alternatywne terminy, takie jak „inteligencja maszyn”, które nie rysują analogii do ludzkiej inteligencji.

Niezależnie od nomenklatury, uczenie maszynowe może przynieść ze sobą bardzo realne i obecne niebezpieczeństwo: naruszenie prywatności użytkowników. Niektóre firmy agresywnie zbierają dane osobowe od użytkowników i przesyłają je do centrów danych, używając uczenia maszynowego i szkolenia jako uzasadnienia.

Jak wspomniano powyżej, Apple robi wiele z tego zbierania i przetwarzania lokalnie na urządzeniu użytkownika. Giannandrea jednoznacznie powiązał tę decyzję z obawami o prywatność. „Myślę, że mamy bardzo jasne stanowisko w tej sprawie, która jest zamierzamy zrobić to uczenie maszynowe zaawansowanej technologii w tak wielu przypadkach, jak to możliwe na urządzeniu użytkownika, a dane nie będzie opuścić urządzenie,” powiedział. „Mamy bardzo jasne oświadczenie o tym, dlaczego uważamy, że nasze urządzenia są bezpieczniejsze lub lepsze lub powinny być bardziej zaufane.”

Używał text-to-speech jako konkretny przykład tej filozofii w akcji:

Jeśli powiesz coś w stylu: „Przeczytaj mi moje wiadomości od Boba”. Synteza tekstu na mowę odbywa się na urządzeniu, na silniku neuronowym – połączeniu silnika neuronowego i procesora. I z tego powodu, nigdy nie widzieliśmy treści wiadomości od Boba, ponieważ telefon odczytuje ją – to nie serwery ją odczytują. Tak więc, treść tej wiadomości nigdy nie trafił do serwera…

Więc jest to świetny przykład zaawansowanej technologii faktycznie poprawia zarówno użyteczność użytkownika, ponieważ głos jest syntetyzowany na urządzeniu, więc nawet jeśli jesteś odłączony, to nadal będzie działać. Ale także w kwestii prywatności. W rzeczywistości jest to naprawdę trudne do zrobienia. Wiele naprawdę twardej inżynierii poszedł do podejmowania nowoczesnych wysokiej jakości być syntetyzowane na urządzeniu, które można umieścić w kieszeni.

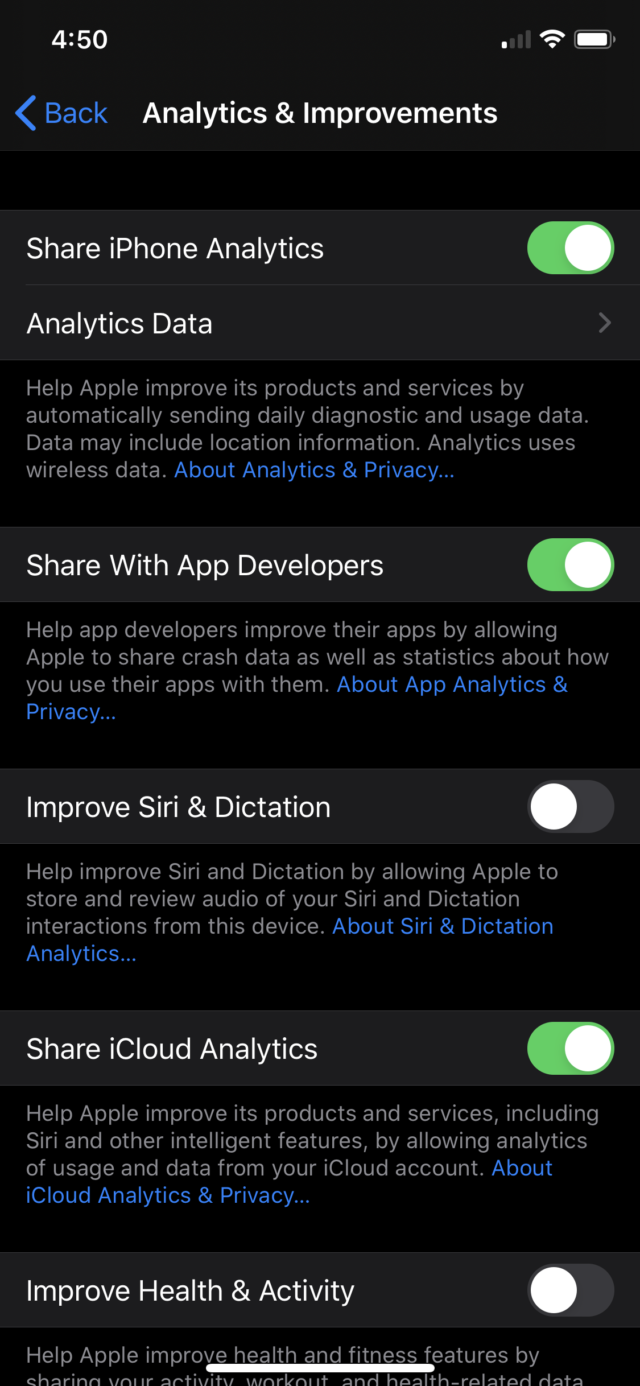

Oczywiście, trzeba użyć niektórych danych użytkownika do uczenia maszynowego w wielu przypadkach. Więc jak dokładnie Apple wykorzystuje dane użytkownika, które obsługuje? Giannandrea wyjaśnił:

Ogólnie rzecz biorąc, mamy dwa sposoby budowania modeli. Jeden to taki, w którym zbieramy i oznaczamy dane, co jest właściwe w wielu, wielu okolicznościach. A potem jest przypadek, w którym prosimy użytkowników o przekazanie swoich danych. Najbardziej znaczącym tego przykładem jest Siri, gdzie podczas konfigurowania iPhone’a pytamy: „Czy chciałbyś pomóc ulepszyć Siri?”

To przypadek, w którym pewna ilość danych jest nam przekazywana, a następnie bardzo niewielki procent z nich może zostać wykorzystany do szkolenia. Ale wiele, wiele rzeczy, o których tu mówimy – powiedzmy, pismo ręczne – możemy zebrać wystarczająco dużo danych, aby wytrenować ten model do pracy z zasadniczo każdym pismem ręcznym bez konieczności korzystania z jakichkolwiek danych konsumenckich w ogóle.

Niektóre z tych monitów z prośbą o wykorzystanie danych użytkownika zostały dodane niedawno. Latem ubiegłego roku raport wskazał, że Siri nagrywała to, co użytkownicy mówili po przypadkowych aktywacjach; wykonawcy, którzy mieli za zadanie zapewnienie jakości funkcjonalności Siri, słyszeli niektóre z tych nagrań.

Apple zareagowało zobowiązując się do przechowywania tylko dźwięku związanego z Siri po tym, jak użytkownicy wyraźnie opowiedzieli się za ulepszeniem Siri poprzez udostępnianie nagrań (to zachowanie zostało wprowadzone w iOS 13.2), a następnie przyniosło całe zapewnienie jakości w firmie. Zapytałem, co Apple robi inaczej niż wykonawcy byli z tych danych. Giannandrea odpowiedział:

Mamy wiele zabezpieczeń. Na przykład, istnieje proces identyfikacji, czy dźwięk był przeznaczony dla asystenta, który jest całkowicie oddzielony od procesu do rzeczywistego przeglądu audio. Robimy więc wiele rzeczy wewnętrznie, aby upewnić się, że nie przechwytujemy – a następnie odrzucamy, w rzeczywistości – żadnego przypadkowego dźwięku.

Ale jeśli nie jesteś skłonny do rzeczywistego QA, do punktu, funkcja, to nigdy nie sprawi, że przypadkowe nagrania będą lepsze. Jak wiesz, uczenie maszynowe wymaga ciągłego ulepszania. Dlatego w tym samym czasie, kiedy przenieśliśmy pracę do firmy, dokonaliśmy gruntownego przeglądu wielu naszych procesów i przepływów pracy. Jestem przekonany, że mamy jeden z najlepszych procesów do poprawy asystenta w sposób zachowujący prywatność.

Jest jasne, że Apple chce wcisnąć ochrony prywatności jako kluczową cechę w swoich urządzeniach; od Giannandrea, to natknął się jako prawdziwe przekonanie. Ale może to również pomóc Apple na rynku, jak jego największy konkurent w przestrzeni mobilnej ma znacznie gorsze wyniki w zakresie prywatności, a to pozostawia otwarcie jak użytkownicy stają się coraz bardziej zaniepokojony implikacjami prywatności AI.

Przez całą naszą rozmowę, zarówno Giannandrea i Borchers wrócił do dwóch punktów strategii Apple: 1) jest to bardziej wydajne, aby zrobić zadania uczenia maszynowego lokalnie, i 2) jest to bardziej „ochrony prywatności” – specyficzne sformułowanie Giannandrea powtórzył kilka razy w naszej rozmowie, aby to zrobić.

Wewnątrz czarnej skrzynki

Po długim okresie pracy nad funkcjami sztucznej inteligencji w ciemno, nacisk Apple na uczenie maszynowe znacznie się zwiększył w ciągu ostatnich kilku lat.

Firma regularnie publikuje, sponsoruje uczelnie, ma stypendia, sponsoruje laboratoria, jeździ na konferencje AI/ML. Ostatnio ponownie uruchomiła blog o uczeniu maszynowym, gdzie dzieli się niektórymi ze swoich badań. To również był na binge zatrudniania, picking się inżynierów i innych w przestrzeni uczenia maszynowego – w tym Giannandrea się zaledwie dwa lata temu.

To nie jest liderem społeczności badawczej w sposób, że Google jest, ale Apple sprawia, że sprawa, że jest wiodącym co najmniej w przynosząc owoce uczenia maszynowego do większej liczby użytkowników.

Pamiętaj, kiedy Giannandrea powiedział, że był zaskoczony, że uczenie maszynowe nie zostały wykorzystane do pisma ręcznego z Pencil? Poszedł dalej, aby zobaczyć tworzenie zespołu, który sprawił, że to się stało. We współpracy z innymi zespołami zajął się on uczeniem maszynowym pisma ręcznego, które stało się kamieniem węgielnym systemu iPadOS 14.

„Mamy w Apple wielu wspaniałych specjalistów od uczenia maszynowego i wciąż ich zatrudniamy” – powiedział Gianandrea. „Uważam, że bardzo łatwo jest przyciągnąć do Apple ludzi światowej klasy, ponieważ w naszych produktach coraz wyraźniej widać, że uczenie maszynowe ma kluczowe znaczenie dla doświadczeń, jakie chcemy zaoferować użytkownikom.”

Po krótkiej przerwie dodał: „Największy problem mam chyba z tym, że wiele z naszych najambitniejszych produktów to te, o których nie możemy mówić, więc powiedzenie komuś: 'Przyjdź i popracuj nad najambitniejszą rzeczą w historii, ale nie mogę Ci powiedzieć, co to jest, jest pewnym wyzwaniem sprzedażowym.'”

Jeśli wierzyć wielkim firmom technologicznym i inwestycjom venture capital, AI i uczenie maszynowe staną się tylko bardziej wszechobecne w nadchodzących latach. Jakkolwiek to się skończy, Giannandrea i Borchers uczynił jedną rzecz jasną: uczenie maszynowe odgrywa teraz rolę w wielu z tego, co Apple robi ze swoimi produktami, a wiele z funkcji konsumenci używają codziennie. A z Neural Engine przychodzi do Macs począwszy od tej jesieni, uczenie maszynowe rola w Apple będzie prawdopodobnie nadal rosnąć.