Her er grunden til, at Apple mener, at Apple er førende inden for AI – og hvorfor kritikerne tager fejl

Machine learning (ML) og kunstig intelligens (AI) gennemsyrer nu næsten alle funktioner på iPhone, men Apple har ikke fremhævet disse teknologier, som nogle af sine konkurrenter har gjort. Jeg ville gerne forstå mere om Apples tilgang , så jeg brugte en time på at tale med to Apple-chefer om virksomhedens strategi – og om konsekvenserne for privatlivets fred af alle de nye funktioner baseret på AI og ML.

Historisk set har Apple ikke haft et offentligt ry for at være førende på dette område. Det skyldes til dels, at folk forbinder AI med digitale assistenter, og anmeldere kalder ofte Siri mindre brugbar end Google Assistant eller Amazon Alexa. Og med ML siger mange teknologi-entusiaster, at flere data betyder bedre modeller – men Apple er ikke kendt for dataindsamling på samme måde som f.eks. Google.

På trods af dette har Apple inkluderet dedikeret hardware til maskinlæringsopgaver i de fleste af de enheder, de leverer. Maskinintelligens-drevne funktioner dominerer i stigende grad de keynotes, hvor Apple-chefer går på scenen for at introducere nye funktioner til iPhones, iPads eller Apple Watch. Introduktionen af Mac-computere med Apple-silicium senere i år vil også bringe mange af de samme maskinintelligensudviklinger til virksomhedens bærbare og stationære computere.

I kølvandet på annonceringen af Apple-silicium talte jeg udførligt med John Giannandrea, Apples Senior Vice President for Machine Learning and AI Strategy, samt med Bob Borchers, VP of Product Marketing. De beskrev Apples AI-filosofi, forklarede, hvordan maskinlæring driver visse funktioner, og argumenterede lidenskabeligt for Apples AI/ML-strategi på enheder.

Hvad er Apples AI-strategi?

Både Giannandrea og Borchers kom til Apple inden for de seneste par år; de har begge tidligere arbejdet hos Google. Borchers kom faktisk tilbage til Apple efter at have været væk i længere tid; han var senior director of marketing for iPhone indtil 2009. Og Giannandreas afhopning fra Google til Apple i 2018 blev bredt omtalt; han havde været Googles chef for AI og søgning.

Google og Apple er ganske forskellige virksomheder. Google har ry for at deltage i, og i nogle tilfælde lede, AI-forskningsmiljøet, mens Apple plejede at udføre det meste af sit arbejde bag lukkede døre. Det har ændret sig i de seneste år, da maskinlæring driver mange funktioner i Apples enheder, og Apple har øget sit engagement i AI-fællesskabet.

“Da jeg kom til Apple, var jeg allerede iPad-bruger, og jeg var vild med Pencil,” fortalte Giannandrea (som kaldes “J.G.” over for kollegerne). “Så jeg sporede softwareholdene og spurgte: “Okay, hvor er det maskinlæringshold, der arbejder på håndskrift? Og jeg kunne ikke finde det.” Det viste sig, at det hold, han ledte efter, ikke eksisterede – en overraskelse, sagde han, i betragtning af at maskinlæring er et af de bedste værktøjer, der findes til funktionen i dag.

“Jeg vidste, at der var så meget maskinlæring, som Apple burde lave, at det var overraskende, at ikke alt faktisk blev gjort. Og det har ændret sig dramatisk i de sidste to til tre år,” sagde han. “Jeg tror helt ærligt, at der ikke er et hjørne af iOS eller Apple-oplevelser, som ikke vil blive transformeret af maskinlæring i løbet af de kommende år.”

Jeg spurgte Giannandrea, hvorfor han følte, at Apple var det rette sted for ham. Hans svar var samtidig et kortfattet resumé af virksomhedens AI-strategi:

Jeg tror, at Apple altid har stået for dette krydsfelt mellem kreativitet og teknologi. Og jeg mener, at når man tænker på at skabe intelligente oplevelser, er det virkelig vigtigt at have vertikal integration hele vejen ned fra applikationerne til rammerne og til siliciumet… Jeg tror, det er en rejse, og jeg tror, at det er fremtiden for de computerenheder, vi har, at de er smarte, og at de smarte slags forsvinder.”

Borchers tilføjede også: “Det er helt klart vores tilgang med alt, hvad vi gør, som er: “Lad os fokusere på, hvad fordelen er, ikke hvordan du er kommet dertil. Og i de bedste tilfælde bliver det automatiseret. Det forsvinder … og man fokuserer bare på, hvad der skete, i modsætning til hvordan det skete.”

Igen i forbindelse med eksemplet med håndskriften argumenterede Giannandrea for, at Apple er bedst placeret til at “lede branchen” med hensyn til at opbygge funktioner og produkter drevet af maskinintelligens:

Vi har lavet pencilen, vi har lavet iPad’en, vi har lavet softwaren til begge. Det er bare unikke muligheder for at gøre et rigtig, rigtig godt stykke arbejde. Hvad er det, vi gør et rigtig, rigtig godt stykke arbejde med? At lade nogen tage noter og være produktive med deres kreative tanker på digitalt papir. Det, jeg er interesseret i, er at se disse oplevelser blive brugt i stor skala i verden.

Han satte dette i kontrast til Google. “Google er et fantastisk firma, og der arbejder nogle virkelig fantastiske teknologer der,” sagde han. “Men grundlæggende er deres forretningsmodel anderledes, og de er ikke kendt for at levere forbrugeroplevelser, der bruges af hundredvis af millioner af mennesker.”

Hvordan bruger Apple maskinlæring i dag?

Apple har gjort det til en vane at kreditere maskinlæring for at forbedre nogle funktioner i iPhone, Apple Watch eller iPad i sine seneste markedsføringspræsentationer, men de går sjældent i detaljer, og de fleste mennesker, der køber en iPhone, har alligevel aldrig set disse præsentationer. Sammenlign dette med f.eks. Google, som sætter AI i centrum for mange af sine budskaber til forbrugerne.

Der er mange eksempler på, at maskinlæring anvendes i Apples software og enheder, hvoraf de fleste er nye inden for blot de seneste par år.

Maskinlæring bruges til at hjælpe iPad’s software med at skelne mellem en bruger, der ved et uheld trykker håndfladen mod skærmen, mens han tegner med Apple Pencil, og et bevidst tryk, der har til hensigt at give et input. Den bruges til at overvåge brugernes brugsvaner for at optimere enhedens batterilevetid og opladning, både for at forbedre den tid, brugerne kan bruge mellem opladningerne, og for at beskytte batteriets levedygtighed på lang sigt. Den bruges til at give app-anbefalinger.

Så er der Siri, som måske er den eneste ting, som enhver iPhone-bruger umiddelbart vil opfatte som kunstig intelligens. Maskinlæring styrer flere aspekter af Siri, lige fra talegenkendelse til Siri’s forsøg på at give nyttige svar.

Kyndige iPhone-ejere vil måske også bemærke, at maskinlæring ligger bag Fotos-appens evne til automatisk at sortere billeder i på forhånd oprettede gallerier eller til præcist at give dig billeder af en veninde ved navn Jane, når hendes navn indtastes i appens søgefelt.

I andre tilfælde er det måske kun få brugere, der er klar over, at maskinlæring er på spil. Din iPhone kan f.eks. tage flere billeder i hurtig rækkefølge, hver gang du trykker på udløserknappen. En ML-trænet algoritme analyserer derefter hvert billede og kan sammensætte det, den anser for at være de bedste dele af hvert billede, til ét resultat.

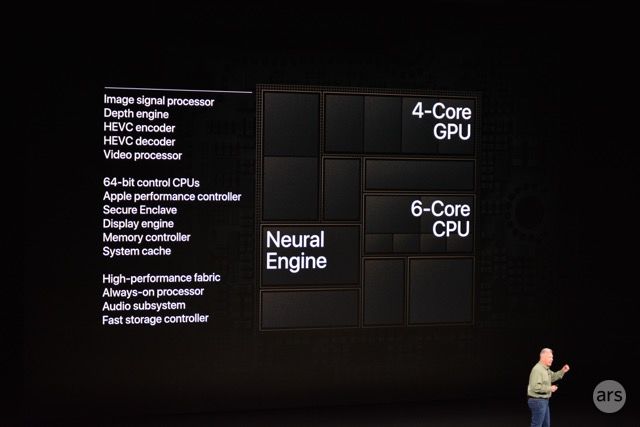

Telefoner har længe indeholdt billedsignalprocessorer (ISP) til at forbedre kvaliteten af fotos digitalt og i realtid, men Apple fremskyndede processen i 2018 ved at lade ISP’en i iPhone arbejde tæt sammen med Neural Engine, virksomhedens nyligt tilføjede processor med fokus på maskinlæring.

Jeg bad Giannandrea nævne nogle af de måder, hvorpå Apple bruger maskinlæring i sin nyere software og produkter. Han gav en vaskeægte liste af eksempler:

Der er en hel masse nye oplevelser, der er drevet af maskinlæring. Og det er ting som sprogoversættelse eller diktering på enheden eller vores nye funktioner omkring sundhed, som f.eks. søvn og håndvask, og ting, vi tidligere har frigivet omkring hjertesundhed og lignende ting. Jeg tror, at der er stadig færre og færre steder i iOS, hvor vi ikke bruger maskinlæring.

Det er svært at finde en del af oplevelsen, hvor man ikke gør noget forudsigende . F.eks. app-prædiktioner eller tastaturprædiktioner, eller moderne smartphone-kameraer foretager en masse maskinlæring bag kulisserne for at finde ud af det, de kalder “saliency”, som er ligesom, hvad er den vigtigste del af billedet? Eller hvis du forestiller dig at sløre baggrunden, så laver du portrættilstand.

Alle disse ting drager fordel af de centrale maskinlæringsfunktioner, der er indbygget i Apple-platformens kerne. Så det er næsten som: “Find mig noget, hvor vi ikke bruger maskinlæring.”

Borchers pegede også på tilgængelighedsfunktioner som vigtige eksempler. “De er grundlæggende gjort tilgængelige og mulige på grund af dette,” sagde han. “Ting som lyddetektionsfunktionen, der er afgørende for det pågældende samfund, er mulige på grund af de investeringer, der er foretaget over tid, og de funktioner, der er indbygget.”

Dertil kommer, at du måske har bemærket, at Apples software- og hardwareopdateringer i de seneste par år har lagt vægt på augmented reality-funktioner. De fleste af disse funktioner er gjort mulige takket være maskinlæring. Per Giannandrea:

Maskinelæring bruges meget i augmented reality. Det svære problem der er det, der kaldes SLAM, altså Simultaneous Localization And Mapping. Så hvis du forsøger at forstå, hvis du har en iPad med en lidar-scanner på, og du bevæger dig rundt, hvad ser den så? Og opbygge en 3D-model af det, den faktisk ser.

Det bruger i dag deep learning, og man skal kunne gøre det på enheden, fordi man ønsker at kunne gøre det i realtid. Det ville ikke give mening, hvis du vifter rundt med din iPad og så måske skal gøre det i datacenteret. Så generelt vil jeg sige, at den måde, jeg tænker på, er, at især deep learning giver os mulighed for at gå fra rå data til semantik om disse data.

I stigende grad udfører Apple maskinlæringsopgaver lokalt på enheden, på hardware som Apple Neural Engine (ANE) eller på virksomhedens specialudviklede GPU’er (grafikprocessorenheder). Giannandrea og Borchers argumenterede, at denne tilgang er det, der gør Apples strategi anderledes end konkurrenternes.

Hvorfor gøre det på enheden?

Både Giannandrea og Borchers fremførte i vores samtale en lidenskabelig sag om, at de funktioner, vi lige har gennemgået, er mulige på grund af – og ikke på trods af – at alt arbejdet udføres lokalt på enheden.

Der er en almindelig fortælling, der koger maskinlæring ned til den idé, at flere data betyder bedre modeller, hvilket igen betyder bedre brugeroplevelser og produkter. Det er en af grundene til, at man ofte peger på Google, Amazon eller Facebook som de sandsynlige herskere over AI-området; disse virksomheder driver massive dataindsamlingsmaskiner, bl.a. fordi de driver og har total indsigt i det, der er blevet en vigtig digital infrastruktur for store dele af verden. Efter den målestok anses Apple af nogle for usandsynligt at klare sig lige så godt, fordi virksomhedens forretningsmodel er anderledes, og fordi den offentligt har forpligtet sig til at begrænse sin dataindsamling.

Da jeg præsenterede disse perspektiver for Giannandrea, holdt han sig ikke tilbage:

Ja, jeg forstår denne opfattelse af, at større modeller i datacentre på en eller anden måde er mere præcise, men det er faktisk forkert. Det er faktisk teknisk set forkert. Det er bedre at køre modellen tæt på dataene i stedet for at flytte rundt på dataene. Og uanset om det er lokaliseringsdata – som f.eks. hvad laver du – træningsdata – hvad gør accelerometeret i din telefon – er det bare bedre at være tæt på datakilden, og det er også en beskyttelse af privatlivets fred.

Borchers og Giannandrea har begge gentagne gange gjort opmærksom på de konsekvenser for privatlivets fred, der er forbundet med at udføre dette arbejde i et datacenter, men Giannandrea sagde, at lokal behandling også handler om ydeevne.

“En af de andre store ting er latenstid,” sagde han. “Hvis du sender noget til et datacenter, er det virkelig svært at gøre noget med billedhastighed. Så vi har masser af apps i app-butikken, der gør ting som f.eks. posestimation, som f.eks. at finde ud af, at personen bevæger sig rundt, og identificere, hvor deres ben og arme er, for eksempel. Det er en API på højt niveau, som vi tilbyder. Det er kun nyttigt, hvis du kan gøre det med billedfrekvens, i det væsentlige.”

Han gav et andet eksempel på et forbrugerbrug:

Du tager et fotografi, og i øjeblikket før du tager et fotografi med kameraet, ser kameraet alt i realtid. Det kan hjælpe dig med at træffe en beslutning om, hvornår du skal tage et fotografi. Hvis du ville træffe den beslutning på serveren, skulle du sende hvert enkelt billede til serveren for at træffe en beslutning om, hvordan du skal tage et fotografi. Det giver ikke nogen mening, vel? Så der er bare masser af oplevelser, som man ønsker at bygge, der er bedre at lave på en edge-enhed.

Spørgsmålet om, hvordan Apple vælger, hvornår noget skal gøres på enheden, var Giannandreas svar ligetil: “

Dertil kommer, at begge Apple-chefer nævnte Apples specialfremstillede silicium – især ANE-siliciumet (Apple Neural Engine), der har været med i iPhones siden iPhone 8 og iPhone X – som en forudsætning for denne on-device-behandling. Neural Engine er en octa-core neural processing unit (NPU), som Apple har designet til at håndtere visse former for maskinlæringsopgaver.

“Det er en flerårig rejse, fordi hardwaren ikke havde været tilgængelig til at gøre dette på kanten for fem år siden”, sagde Giannandrea. “ANE-designet er fuldstændig skalerbart. Der er en større ANE i en iPad, end der er i en telefon, end der er i et Apple Watch, men CoreML API-laget til vores apps og også til udviklerapps er grundlæggende det samme på tværs af hele produktserien.”

Når Apple har talt offentligt om Neural Engine, har virksomheden delt ydelsestal, såsom 5 billioner operationer pr. sekund i 2018’s A12-chip. Men det er ikke blevet specifikt om arkitekturen i chippen. Det er bogstaveligt talt en sort boks på slides i Apples præsentationer.

Da ville jeg gerne vide, om Giannandrea ville kaste mere lys over, hvordan Neural Engine fungerer under motorhjelmen, men han afviste at gå meget i detaljer. I stedet sagde han, at app-udviklere kan hente alt, hvad de har brug for at vide, i CoreML – et softwareudviklings-API, der giver udviklere adgang til iPhone’s maskinlæringsmuligheder.

CoreML-udvikler-API’et beskriver meget tydeligt de typer maskinlæringsmodeller, runtime-modeller, som vi understøtter… Vi har et stigende sæt kerner, som vi understøtter. Og du målretter CoreML fra en hvilken som helst af de populære maskinlæringsting som PyTorch eller TensorFlow, og så kompilerer du i det væsentlige din model, og så giver du den til CoreML.

CoreML’s opgave er at finde ud af, hvor den model skal køres. Det kan være, at det rigtige er at køre modellen på ANE, men det kan også være det rigtige at køre modellen på GPU’en eller at køre modellen på CPU’en. Og vores CPU har også optimeringer til maskinlæring.

Igennem vores samtale pegede begge chefer lige så meget på tredjepartsudvikleres apps som på Apples egne. Strategien her er ikke kun at drive Apple-producerede tjenester og funktioner; det er at åbne i det mindste noget af denne kapacitet op for det store fællesskab af udviklere. Apple har været afhængig af udviklere til at innovere på sine platforme, siden App Store blev åbnet i 2008. Virksomheden låner ofte ideer, som disse udviklere har fundet på, når de opdaterer deres egne, internt fremstillede apps.

Apples enheder er naturligvis ikke de eneste med indbyggede maskinlæringschips. Samsung, Huawei og Qualcomm har f.eks. alle NPU’er i deres systemer-på-en-chip. Og Google tilbyder også API’er til maskinlæring til udviklere. Alligevel er Googles strategi og forretningsmodel markant anderledes. Android-telefoner klarer ikke nær så bredt et udvalg af maskinlæringsopgaver lokalt.

Macs med Apple-silicium

Fokus i mit interview med Giannandrea og Borchers var ikke på den store meddelelse, som virksomheden kom med på WWDC for blot et par uger siden – den forestående lancering af Macs med Apple-silicium. Men da jeg spekulerede i, at en af Apples mange grunde til at designe Macs omkring selskabets egne chips kunne være medtagelsen af Neural Engine, sagde Borchers:

Vi vil for første gang have en fælles platform, en siliciumplatform, der kan understøtte det, som vi ønsker at gøre, og det, som vores udviklere ønsker at gøre…. Den evne vil frigøre nogle interessante ting, som vi kan tænke på, men nok endnu vigtigere vil den frigøre en masse ting for andre udviklere, efterhånden som de kommer videre.

Giannandrea gav et konkret eksempel på, hvordan Apples maskinlæringsværktøjer og hardware vil blive brugt på Mac’en:

Jeg ved ikke, om du så den demo i State of the Union, men grundlæggende var idéen: Givet en video, gå igennem videoen billede for billede eller billede for billede og lav objektdetektering. Og man kan gøre det mere end en størrelsesorden hurtigere på vores silicium end på den gamle platform.

Og så siger man: “Nå, det er interessant. Men hvorfor er det så nyttigt?” Forestil dig en videoredigering, hvor du havde et søgefelt, og du kunne sige: “Find mig pizzaen på bordet”. Og så ville den bare scrubbe til det billede… Det er den slags oplevelser, som jeg tror, at du vil se folk finde på. Vi ønsker i høj grad, at udviklerne bruger disse rammer og bare overrasker os med, hvad de rent faktisk kan gøre med det.

Apple sagde på sin udviklerkonference, at selskabet planlægger at levere Mac-computere med eget silicium fra senere i år.

Hvad med privatlivets fred?

Privatlivets fred har stået i centrum for Apples budskaber til brugerne i de seneste par år. Det er blevet nævnt igen og igen i keynotes og markedsføringsmaterialer, der er påmindelser om det i iOS, og det kommer ofte på tale i interviews – hvilket også var tilfældet med dette interview.

“Folk er bekymrede over AI generelt, fordi de ikke ved, hvad det er,” fortalte Giannandrea mig. “De tror, at den er mere kompetent, end den er, eller de tænker på dette sci-fi-syn på AI, og du har indflydelsesrige personer som Bill Gates og Elon Musk og andre, der siger, at det er en farlig teknologi.”

Han mener, at hypen omkring AI fra andre store teknologivirksomheder er negativ, ikke positiv, for disse virksomheders markedsføringsindsats, “fordi folk er bekymrede for denne teknologi.”

Begrebet “AI” er måske ikke nyttigt her. Det fremkalder ondsindede syntetiske skurke fra popkulturen, som Skynet eller HAL 9000. Men de fleste eksperter i anvendt kunstig intelligens vil fortælle dig, at dette mørke udfald er langt fra virkeligheden. Teknologi drevet af maskinlæring indebærer mange risici – f.eks. at den arver og forstærker menneskelige fordomme – men at den går amok og angriber menneskeheden med vold virker ikke sandsynligt i den nærmeste fremtid.

Maskinlæring gør faktisk ikke maskiner intelligente på samme måde som mennesker. Af denne og andre grunde har mange AI-eksperter (herunder Giannandrea) foreslået alternative betegnelser som “maskinintelligens”, der ikke drager paralleller til menneskelig intelligens.

Hvilken nomenklatur der end måtte være tale om, kan maskinlæring medføre en meget reel og nærværende fare: underminering af brugernes privatliv. Nogle virksomheder indsamler aggressivt personlige data fra brugerne og uploader dem til datacentre med maskinlæring og træning som begrundelse.

Som nævnt ovenfor foretager Apple en stor del af denne indsamling og behandling lokalt på brugerens enhed. Giannandrea knyttede udtrykkeligt denne beslutning til hensynet til privatlivets fred. “Jeg tror, at vi har en meget klar holdning til dette, som er, at vi vil udføre denne avancerede teknologi til maskinlæring i så mange tilfælde som muligt på din enhed, og dataene vil ikke forlade din enhed,” sagde han. “Vi har en meget klar udtalelse om, hvorfor vi mener, at vores enheder er mere sikre eller bedre eller bør have større tillid.”

Han brugte tekst-til-tale som et konkret eksempel på denne filosofi i praksis:

Hvis du siger noget som: “Læs mig mine beskeder fra Bob.” Syntesen af teksten til tale sker på enheden, på den neurale motor – kombinationen af den neurale motor og CPU’en. Og på grund af det har vi aldrig set indholdet af din besked fra Bob, fordi din telefon læser den op – det er ikke serverne, der læser den op. Så indholdet af den besked nåede aldrig frem til serveren…

Så det er et godt eksempel på avanceret teknologi, der faktisk forbedrer både brugervenligheden, fordi stemmen bliver syntetiseret på enheden, så selv hvis du ikke har forbindelse, vil den stadig fungere, selv om du ikke har forbindelse. Men også historien om privatlivets fred. Det er faktisk meget svært at gøre. Der er brugt en masse virkelig hård ingeniørarbejde på at få moderne høj kvalitet syntetiseret på en enhed, som du kan putte i lommen.

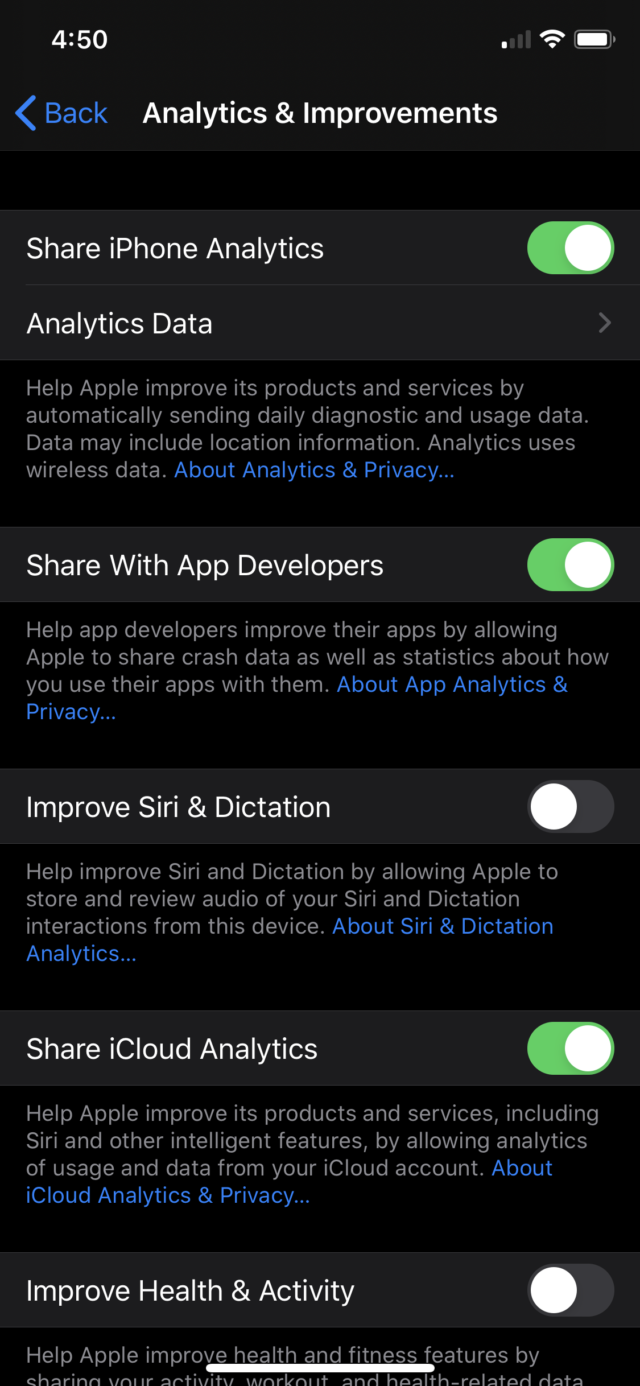

Naturligvis skal du i mange tilfælde bruge nogle brugerdata til maskinlæring. Så hvordan bruger Apple helt præcist de brugerdata, som de håndterer? Giannandrea forklarede:

Generelt set har vi to måder, hvorpå vi opbygger modeller. Den ene er, hvor vi indsamler og mærker data, hvilket er hensigtsmæssigt under mange, mange omstændigheder. Og så er der det tilfælde, hvor vi beder brugerne om at donere deres data. Det mest bemærkelsesværdige eksempel på det er Siri, hvor vi, når du indstiller en iPhone, siger: “Vil du gerne hjælpe med at gøre Siri bedre?”

Det er et tilfælde, hvor en vis mængde data doneres til os, og en meget lille procentdel af dem kan bruges til træning. Men mange, mange ting, vi taler om her – som f.eks. håndskrift – kan vi indsamle data nok til at træne modellen til at fungere med stort set alles håndskrift uden at skulle bruge nogen forbrugerdata overhovedet.

Nogle af disse opfordringer med anmodning om at bruge dine data er blevet tilføjet for nylig. Sidste sommer viste en rapport, at Siri optog, hvad brugerne sagde efter utilsigtede aktiveringer; entreprenører, der havde til opgave at kvalitetssikre Siris funktionalitet, hørte nogle af disse optagelser.

Apple reagerede ved at forpligte sig til kun at lagre Siri-relateret lyd, efter at brugerne udtrykkeligt har valgt at gøre Siri bedre ved at dele optagelser (denne adfærd blev indført i iOS 13.2), og bragte derefter al kvalitetssikring internt. Jeg spurgte, hvad Apple gør anderledes end entreprenørerne gjorde med disse data. Giannandrea svarede:

Vi har en masse sikkerhedsforanstaltninger. Der er f.eks. en proces til at identificere, om lyden var beregnet til assistenten eller ej, hvilket er helt adskilt fra processen til faktisk at gennemgå lyden. Så vi gør en masse ting internt for at sikre, at vi ikke optager – og så faktisk kasserer – nogen utilsigtet lyd.

Men hvis du ikke er villig til rent faktisk at kvalitetssikre funktionen, for at komme til din pointe, så vil du aldrig gøre de utilsigtede optagelser bedre. Som du ved, kræver maskinlæring, at du hele tiden forbedrer den. Så vi reviderede faktisk en masse af vores arbejdsgange og processer samtidig med, at vi bragte arbejdet internt. Jeg er meget overbevist om, at vi har en af de allerbedste processer til at forbedre assistenten på en måde, der bevarer privatlivets fred.

Det er tydeligt, at Apple ønsker at fremme beskyttelsen af privatlivets fred som en nøglefunktion i sine enheder; fra Giannandrea kom det til at fremstå som en ægte overbevisning. Men det kan også hjælpe Apple på markedet, da den største konkurrent på mobilområdet har langt dårligere resultater med hensyn til privatlivets fred, og det efterlader en åbning, efterhånden som brugerne bliver mere og mere bekymrede over konsekvenserne af kunstig intelligens for privatlivets fred.

I løbet af vores samtale kom både Giannandrea og Borchers tilbage til to punkter i Apples strategi: 1) det er mere performant at udføre maskinlæringsopgaver lokalt, og 2) det er mere “privatlivsbevarende” – en specifik formulering, som Giannandrea gentog et par gange i vores samtale – at gøre det.

Indenfor den sorte boks

Efter at have arbejdet med AI-funktioner mest i det skjulte har Apple i de seneste par år lagt stor vægt på maskinlæring.

Selskabet udgiver regelmæssigt, det laver akademiske sponsorater, det har fellowships, det sponsorerer laboratorier, det tager til AI/ML-konferencer. Virksomheden har for nylig relanceret en blog om maskinlæring, hvor den deler noget af sin forskning. Virksomheden har også været i gang med at ansætte mange ingeniører og andre inden for maskinlæring – herunder Giannandrea selv for bare to år siden.

Det er ikke førende i forskningsverdenen på samme måde som Google, men Apple gør det klart, at virksomheden i det mindste er førende i forhold til at bringe frugterne af maskinlæring ud til flere brugere.

Kan du huske, da Giannandrea sagde, at han var overrasket over, at maskinlæring ikke blev brugt til håndskrift med Pencil? Han fortsatte med at se oprettelsen af det team, der fik det til at ske. Og i samarbejde med andre teams gik de videre med maskinlæringsdrevet håndskrift – en hjørnesten i iPadOS 14.

“Vi har en masse fantastiske maskinlæringsfolk hos Apple, og vi fortsætter med at ansætte dem,” sagde Gianandrea. “Jeg synes, det er meget nemt at tiltrække folk i verdensklasse til Apple, fordi det bliver mere og mere tydeligt i vores produkter, at maskinlæring er afgørende for de oplevelser, som vi ønsker at skabe for brugerne.”

Efter en kort pause tilføjede han: “Jeg tror, at det største problem, jeg har, er, at mange af vores mest ambitiøse produkter er dem, vi ikke kan tale om, og derfor er det lidt af en salgsudfordring at sige til nogen: ‘Kom og arbejd med på den mest ambitiøse ting nogensinde, men jeg kan ikke fortælle dig, hvad det er.'”

Hvis man skal tro de store teknologivirksomheder og venturekapitalinvesteringer, vil AI og maskinlæring kun blive mere allestedsnærværende i de kommende år. Uanset hvordan det kommer til at gå, gjorde Giannandrea og Borchers én ting klart: Maskinlæring spiller nu en rolle i meget af det, Apple gør med sine produkter, og mange af de funktioner, som forbrugerne bruger dagligt. Og med Neural Engine, der kommer til Mac-computere fra dette efterår, vil maskinlæringens rolle hos Apple sandsynligvis fortsætte med at vokse.