Så här tror Apple att de är ledande inom AI – och varför kritikerna har fel

Maskininlärning (ML) och artificiell intelligens (AI) genomsyrar nu nästan alla funktioner i iPhone, men Apple har inte marknadsfört dessa tekniker på samma sätt som några av sina konkurrenter har gjort. Jag ville förstå mer om Apples tillvägagångssätt, så jag tillbringade en timme med att prata med två Apple-chefer om företagets strategi – och om konsekvenserna för privatlivet av alla nya funktioner som bygger på artificiell intelligens och ML.

Historiskt sett har Apple inte haft något offentligt rykte om sig att vara ledande på det här området. Det beror delvis på att folk förknippar AI med digitala assistenter, och recensenter kallar ofta Siri för mindre användbar än Google Assistant eller Amazon Alexa. Och när det gäller ML säger många teknikentusiaster att mer data innebär bättre modeller – men Apple är inte känt för datainsamling på samma sätt som till exempel Google.

Trots detta har Apple inkluderat dedikerad hårdvara för maskininlärningsuppgifter i de flesta av de enheter som levereras. Maskinintelligensdriven funktionalitet dominerar alltmer de keynotes där Apples chefer går upp på scenen för att presentera nya funktioner för iPhones, iPads eller Apple Watch. När Macs med Apples kisel introduceras senare i år kommer många av samma maskinintelligensutveckling även att komma till företagets bärbara och stationära datorer.

I kölvattnet av tillkännagivandet av Apples kisel talade jag utförligt med John Giannandrea, Apples vice ordförande för maskininlärning och AI-strategi, samt med Bob Borchers, vice ordförande för produktmarknadsföring. De beskrev Apples AI-filosofi, förklarade hur maskininlärning driver vissa funktioner och argumenterade passionerat för Apples AI/ML-strategi för enheter.

Vad är Apples AI-strategi?

Både Giannandrea och Borchers kom till Apple under de senaste åren; båda arbetade tidigare på Google. Borchers kom faktiskt tillbaka till Apple efter att ha varit borta en tid; han var senior director of marketing för iPhone fram till 2009. Och Giannandreas avhopp från Google till Apple 2018 rapporterades flitigt; han hade varit Googles chef för AI och sökning.

Google och Apple är helt olika företag. Google har ett rykte om sig att delta i, och i vissa fall leda, AI-forskningsvärlden, medan Apple brukade göra det mesta av sitt arbete bakom stängda dörrar. Detta har förändrats under de senaste åren, eftersom maskininlärning driver många funktioner i Apples enheter och Apple har ökat sitt engagemang i AI-samhället.

”När jag började på Apple var jag redan iPad-användare och jag älskade pennan”, berättade Giannandrea (som kallas ”J.G.” av kollegorna). ”Så jag spårade upp programvaruteamen och frågade: ’Okej, var finns teamet för maskininlärning som arbetar med handskrift? Och jag kunde inte hitta det.” Det visade sig att teamet han letade efter inte fanns – en överraskning, sa han, med tanke på att maskininlärning är ett av de bästa verktygen som finns tillgängliga för funktionen idag.

”Jag visste att det fanns så mycket maskininlärning som Apple borde göra att det var förvånande att inte allt faktiskt gjordes. Och det har förändrats dramatiskt under de senaste två till tre åren”, säger han. ”Jag tror verkligen att det inte finns ett enda hörn av iOS eller Apple-upplevelser som inte kommer att förändras av maskininlärning under de kommande åren.”

Jag frågade Giannandrea varför han kände att Apple var rätt plats för honom. Hans svar var en kortfattad sammanfattning av företagets AI-strategi:

Jag tror att Apple alltid har stått för den skärningspunkten mellan kreativitet och teknik. Och jag tror att när man funderar på att bygga smarta upplevelser är vertikal integration, hela vägen ner från tillämpningar till ramar och kisel, verkligen viktigt… Jag tror att det är en resa, och jag tror att framtiden för de datorer vi har är att de är smarta, och att det smarta på något sätt försvinner.

Borchers gav också sitt bidrag och tillade: ”Det här är helt klart vårt tillvägagångssätt, med allt vi gör, vilket är: ’Låt oss fokusera på vad nyttan är, inte på hur du har kommit dit’. Och i de bästa fallen blir det automatiskt. Det försvinner … och du fokuserar bara på vad som hände, i motsats till hur det hände.”

När Giannandrea återigen talade om handskriftsexemplet argumenterade han för att Apple är bäst positionerat för att ”leda branschen” när det gäller att bygga funktioner och produkter som bygger på maskinell intelligens:

Vi har tillverkat pennan, vi har tillverkat iPaden, vi har tillverkat programvaran för båda. Det är bara unika möjligheter att göra ett riktigt, riktigt bra jobb. Vad gör vi ett riktigt, riktigt bra jobb på? Att låta någon anteckna och vara produktiv med sina kreativa tankar på digitalt papper. Det jag är intresserad av är att se dessa erfarenheter användas i stor skala i världen.

Han jämförde detta med Google. ”Google är ett fantastiskt företag och det finns några riktigt bra teknologer som arbetar där”, sade han. ”Men i grunden är deras affärsmodell annorlunda och de är inte kända för att leverera konsumentupplevelser som används av hundratals miljoner människor.”

Hur använder Apple maskininlärning idag?

Apple har gjort det till en vana att i sina senaste marknadsföringspresentationer tillskriva maskininlärning för att ha förbättrat vissa funktioner i iPhone, Apple Watch eller iPad, men företaget går sällan in på detaljer – och de flesta människor som köper en iPhone har ändå aldrig tittat på dessa presentationer. Jämför detta med till exempel Google, som sätter AI i centrum för många av sina meddelanden till konsumenterna.

Det finns många exempel på att maskininlärning används i Apples mjukvara och enheter, varav de flesta är nya bara under de senaste åren.

Maskinininlärning används för att hjälpa iPads mjukvara att skilja mellan en användare som råkar trycka handflatan mot skärmen när han/hon ritar med Apple Pencil, och en avsiktlig tryckning som är tänkt att ge en inmatning. Den används för att övervaka användarnas användningsvanor för att optimera enhetens batteritid och laddning, både för att förbättra den tid som användarna kan tillbringa mellan laddningarna och för att skydda batteriets långsiktiga livskraft. Den används för att ge apprekommendationer.

Sedan har vi Siri, som kanske är det enda som alla iPhone-användare omedelbart skulle uppfatta som artificiell intelligens. Maskininlärning driver flera aspekter av Siri, från taligenkänning till försök av Siri att ge användbara svar.

Smarta iPhone-ägare kanske också märker att maskininlärning ligger bakom appen Fotos förmåga att automatiskt sortera bilder i färdiga gallerier, eller att exakt ge dig bilder av en vän som heter Jane när hennes namn skrivs in i appens sökfält.

I andra fall är det kanske få användare som inser att maskininlärning är i arbete. Din iPhone kan till exempel ta flera bilder i snabb följd varje gång du trycker på avtryckaren. En ML-tränad algoritm analyserar sedan varje bild och kan sätta ihop vad den anser vara de bästa delarna av varje bild till ett resultat.

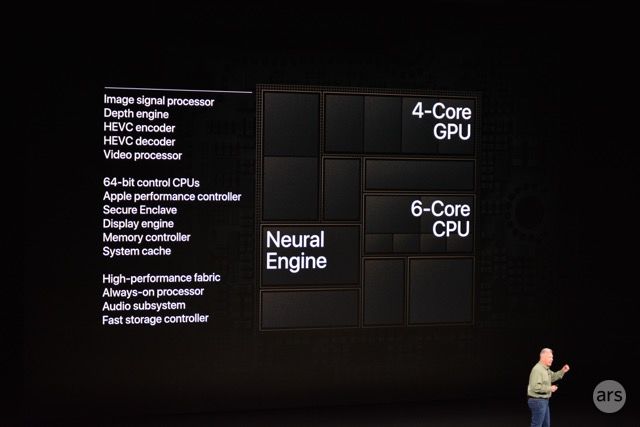

Phones har länge haft bildsignalprocessorer (ISP) för att förbättra fotokvaliteten digitalt och i realtid, men Apple påskyndade processen 2018 genom att låta ISP:n i iPhone arbeta nära Neural Engine, företagets nyligen tillkomna processor med inriktning på maskininlärning.

Jag bad Giannandrea nämna några av de sätt som Apple använder sig av maskininlärning i sin senaste mjukvara och produkter. Han gav en tvättlista med exempel:

Det finns en hel massa nya upplevelser som drivs av maskininlärning. Och dessa är saker som språköversättning, eller diktering på enheten, eller våra nya funktioner kring hälsa, som sömn och handtvätt, och saker som vi har släppt tidigare kring hjärthälsa och liknande saker. Jag tror att det blir allt färre och färre ställen i iOS där vi inte använder maskininlärning.

Det är svårt att hitta en del av upplevelsen där man inte gör någon förutsägelse . Till exempel app- eller tangentbordsförutsägelser eller moderna smartphonekameror gör massor av maskininlärning bakom kulisserna för att ta reda på vad de kallar ”saliency”, vilket innebär att man frågar sig vad som är den viktigaste delen av bilden. Eller om du tänker dig att sudda ut bakgrunden, så gör du porträttläge.

Alla dessa saker drar nytta av de centrala maskininlärningsfunktioner som är inbyggda i Apples kärnplattform. Så det är nästan som att ”hitta något där vi inte använder maskininlärning”.

Borchers pekade också på tillgänglighetsfunktioner som viktiga exempel. ”De är i grunden tillgängliga och möjliga tack vare detta”, sade han. ”Saker som ljuddetekteringsfunktionen, som är avgörande för just det samhället, är möjliga tack vare investeringarna över tid och de funktioner som är inbyggda.”

Du kanske har lagt märke till att Apples mjukvaru- och hårdvaruuppdateringar under de senaste åren har betonat augmented reality-funktioner. De flesta av dessa funktioner möjliggörs tack vare maskininlärning. Per Giannandrea:

Maskininlärning används mycket inom förstärkt verklighet. Det svåra problemet där är det som kallas SLAM, alltså Simultaneous Localization And Mapping. Så om du har en iPad med en lidar-scanner på den och du rör dig runt, vad ser den då? Och bygga upp en 3D-modell av vad den faktiskt ser.

Det är en fråga om djupinlärning och man måste kunna göra det på enheten eftersom man vill kunna göra det i realtid. Det skulle inte vara meningsfullt om du viftar med din iPad och sedan kanske måste göra det i datacentret. Så generellt sett skulle jag säga att jag tänker på detta genom att särskilt djupinlärning ger oss möjlighet att gå från rådata till semantik om dessa data.

I allt högre grad utför Apple maskininlärningsuppgifter lokalt på enheten, på hårdvara som Apple Neural Engine (ANE) eller på företagets specialdesignade GPU:er (grafikprocessorer). Giannandrea och Borchers hävdade att det är detta tillvägagångssätt som gör att Apples strategi skiljer sig från konkurrenternas.

Varför göra det på enheten?

Både Giannandrea och Borchers argumenterade i vår konversation för att de funktioner som vi just gick igenom är möjliga på grund av – och inte trots – det faktum att allt arbete utförs lokalt på enheten.

Det finns en vanlig berättelse som kokar ner maskininlärning till idén att mer data innebär bättre modeller, vilket i sin tur innebär bättre användarupplevelser och produkter. Det är en av anledningarna till att observatörer ofta pekar ut Google, Amazon eller Facebook som troliga härskare över AI-striden; dessa företag driver massiva datainsamlingsmaskiner, delvis för att de driver och har total insyn i vad som har blivit viktig digital infrastruktur för stora delar av världen. Enligt det måttet bedöms Apple av vissa som osannolikt att prestera lika bra, eftersom dess affärsmodell är annorlunda och företaget offentligt har åtagit sig att begränsa sin datainsamling.

När jag presenterade dessa perspektiv för Giannandrea höll han sig inte tillbaka:

Ja, jag förstår den här uppfattningen om att större modeller i datacentraler på något sätt är mer korrekta, men det är faktiskt fel. Det är faktiskt tekniskt sett fel. Det är bättre att köra modellen nära data än att flytta runt data. Oavsett om det handlar om lokaliseringsdata, till exempel vad du gör, träningsdata, vad accelerometern i din telefon gör, är det bara bättre att vara nära datakällan, så det är också integritetsbevarande.

Borchers och Giannandrea påpekade båda upprepade gånger att det är viktigt för integritetsskyddet att göra det här arbetet i ett datacenter, men Giannandrea sa att lokal bearbetning också handlar om prestanda.

”En av de andra stora sakerna är latenstid”, sa han. ”Om du skickar något till ett datacenter är det verkligen svårt att göra något med bildfrekvens. Så vi har många appar i appbutiken som gör saker, till exempel uppskattning av positionen, som att räkna ut hur personen rör sig och identifiera var benen och armarna är, till exempel. Det är ett API på hög nivå som vi erbjuder. Det är bara användbart om du kan göra det med bildfrekvens, i princip.”

Han gav ett annat exempel på ett användningsområde för konsumenter:

Du tar ett fotografi och ögonblicken innan du tar ett fotografi med kameran ser kameran allt i realtid. Den kan hjälpa dig att fatta ett beslut om när du ska ta ett fotografi. Om du ville fatta det beslutet på servern skulle du behöva skicka varje enskild bild till servern för att fatta ett beslut om hur du ska ta ett fotografi. Det är väl inte vettigt, eller hur? Så det finns massor av upplevelser som du vill bygga som är bättre gjorda på en edge-enhet.

På frågan om hur Apple väljer när något ska göras på enheten var Giannandreas svar rakt på sak: ”När vi kan uppnå eller överträffa kvaliteten på det vi kan göra på servern.”

Båda Apple-cheferna uppgav dessutom att Apples specialanpassade kisel – särskilt ANE-kisel (Apple Neural Engine) som ingår i iPhone 8 och iPhone X – är en förutsättning för denna bearbetning på enheten. Neural Engine är en octa-core neural processorenhet (NPU) som Apple designat för att hantera vissa typer av maskininlärningsuppgifter.

”Det är en flerårig resa eftersom hårdvaran inte hade funnits tillgänglig för att göra det här vid kanten för fem år sedan”, sade Giannandrea. ”ANE-designen är helt skalbar. Det finns en större ANE i en iPad än i en telefon, än i en Apple Watch, men CoreML API-lagret för våra appar och även för utvecklarappar är i princip detsamma i hela produktlinjen.”

När Apple har pratat offentligt om Neural Engine har företaget delat med sig av prestandasiffror, till exempel 5 biljoner operationer per sekund i 2018 års A12-chip. Men det har inte blivit specifikt om chipets arkitektur. Det är bokstavligen en svart låda på bildbladen i Apples presentationer.

Med tanke på detta ville jag veta om Giannandrea skulle kasta mer ljus över hur Neural Engine fungerar under huven, men han avböjde att gå in på mycket detaljer. Istället sa han att apputvecklare kan hämta allt de behöver veta från CoreML – ett programvaruutvecklings-API som ger utvecklare tillgång till iPhones möjligheter till maskininlärning.

CoreML-utvecklings-API:et beskriver mycket tydligt vilka typer av modeller för maskininlärning, körtidsmodeller som vi stöder… Vi har en ökande uppsättning kärnor som vi stöder. Och du riktar dig till CoreML från någon av de populära maskininlärningssakerna, som PyTorch eller TensorFlow, och sedan kompilerar du i huvudsak din modell och ger den till CoreML.

CoreML:s uppgift är att ta reda på var modellen ska köras. Det kan vara rätt att köra modellen på ANE, men det kan också vara rätt att köra modellen på GPU eller på CPU. Och vår CPU har optimeringar för maskininlärning också.

Under vårt samtal pekade båda cheferna lika mycket på tredjepartsutvecklarnas appar som på Apples egna. Strategin här är inte bara att driva Apple-tillverkade tjänster och funktioner, utan att öppna upp åtminstone en del av denna kapacitet för den stora gruppen av utvecklare. Apple har förlitat sig på att utvecklare ska förnya sina plattformar sedan App Store öppnades 2008. Företaget lånar ofta idéer som dessa utvecklare kommit på när de uppdaterar sina egna, internt tillverkade appar.

Apples enheter är förstås inte de enda som har maskininlärningschips inbyggda. Samsung, Huawei och Qualcomm har alla NPU:er i sina system-on-a-chip, till exempel. Och även Google erbjuder API:er för maskininlärning till utvecklare. Ändå är Googles strategi och affärsmodell markant annorlunda. Android-telefoner utför inte alls lika många olika maskininlärningsuppgifter lokalt.

Macs med Apples kisel

Fokus i min intervju med Giannandrea och Borchers låg inte på det stora tillkännagivande som företaget gjorde vid WWDC för bara några veckor sedan – den nära förestående lanseringen av Macs med Apples kisel. Men när jag spekulerade i att en av Apples många anledningar att utforma Macs med egna chip kan vara att inkludera Neural Engine, sa Borchers:

Vi kommer för första gången att ha en gemensam plattform, en kiselplattform som kan stödja vad vi vill göra och vad våra utvecklare vill göra…. Den förmågan kommer att låsa upp en del intressanta saker som vi kan tänka oss, men förmodligen ännu viktigare är att den kommer att låsa upp många saker för andra utvecklare allteftersom.

Giannandrea gav ett specifikt exempel på hur Apples verktyg och hårdvara för maskininlärning kommer att användas på Mac:

Jag vet inte om du såg den där demonstrationen i State of the Union, men i princip var idén: om du får en video, går du igenom videon bild för bild och gör objektsökning. Och du kan göra det mer än en storleksordning snabbare på vårt kisel än på den gamla plattformen.

Och sedan säger du: ”Ja, det är intressant. Varför är det användbart?” Tänk dig en videoredigerare där du har en sökruta och kan säga: ”Hitta pizzan på bordet”. Och det skulle bara skrubba till den bilden… Det är den typen av upplevelser som jag tror att folk kommer att hitta på. Vi vill verkligen att utvecklarna ska använda dessa ramar och överraska oss med vad de faktiskt kan göra med dem.

Apple sa vid sin utvecklarkonferens att man planerar att leverera Macs med eget kisel från och med senare i år.

Hur blir det med integriteten?

Privatlivet har stått i centrum i Apples meddelanden till användarna under de senaste åren. Det tas upp om och om igen i keynotes och marknadsföringsmaterial, det finns påminnelser om det i iOS och det kommer ofta upp i intervjuer – vilket också var fallet med den här intervjun.

”Folk är oroliga för AI i stort eftersom de inte vet vad det är”, berättade Giannandrea för mig. ”De tror att den är mer kapabel än vad den är, eller så tänker de på den här sci-fi-synen på AI, och du har inflytelserika personer som Bill Gates och Elon Musk och andra som säger att det här är en farlig teknik.”

Han tror att hypen kring AI från andra stora teknikföretag är negativ, inte positiv, för dessa företags marknadsföringsinsatser ”eftersom folk är oroliga för den här tekniken”.

Tecknet ”AI” är kanske inte till någon hjälp här. Det påminner om ondskefulla syntetiska skurkar från populärkulturen, som Skynet eller HAL 9000. Men de flesta experter på tillämpad artificiell intelligens kommer att säga att detta mörka utfall är långt ifrån verkligheten. Teknik som drivs av maskininlärning medför många risker – till exempel att den ärver och förstärker mänskliga fördomar – men att den blir oseriös och attackerar mänskligheten på ett våldsamt sätt verkar inte troligt inom den närmaste framtiden.

Maskinininlärning gör faktiskt inte maskinerna intelligenta på samma sätt som människor är det. Av bland annat denna anledning har många AI-experter (däribland Giannandrea) föreslagit alternativa termer som ”maskinintelligens” som inte drar paralleller till mänsklig intelligens.

Oavsett nomenklaturen kan maskininlärning medföra en mycket reell och närvarande fara: undergrävande av användarnas integritet. Vissa företag samlar aggressivt in personuppgifter från användare och laddar upp dem till datacenter, med maskininlärning och träning som motivering.

Som nämnts ovan gör Apple en stor del av denna insamling och bearbetning lokalt på användarens enhet. Giannandrea kopplade uttryckligen detta beslut till integritetsfrågor. ”Jag tror att vi har en mycket tydlig ståndpunkt om detta, vilket är att vi kommer att göra denna avancerade teknik för maskininlärning i så många fall som möjligt på din enhet, och uppgifterna kommer inte att lämna din enhet”, sade han. ”Vi har ett mycket tydligt uttalande om varför vi anser att våra enheter är säkrare eller bättre eller bör vara mer betrodda.”

Han använde text-till-tal som ett specifikt exempel på denna filosofi i praktiken:

Om du säger något i stil med: ”Läs upp mina meddelanden från Bob”. Syntesen av texten till tal sker på enheten, på Neural Engine – kombinationen av Neural Engine och CPU. På grund av detta har vi aldrig sett innehållet i ditt meddelande från Bob eftersom din telefon läser upp det – det är inte servrarna som läser upp det. Så innehållet i meddelandet nådde aldrig fram till servern…

Det är ett bra exempel på avancerad teknik som faktiskt förbättrar både användarnyttan eftersom rösten syntetiseras på enheten, så även om du är bortkopplad fungerar det fortfarande. Men också integritetsaspekten. Det är faktiskt väldigt svårt att göra. Det har krävts en hel del mycket hård ingenjörskonst för att göra modern högkvalitativ syntes på en enhet som du kan stoppa i fickan.

Naturligtvis måste man i många fall använda vissa användardata för maskininlärning. Så hur exakt använder Apple de användardata som de hanterar? Giannandrea förklarade:

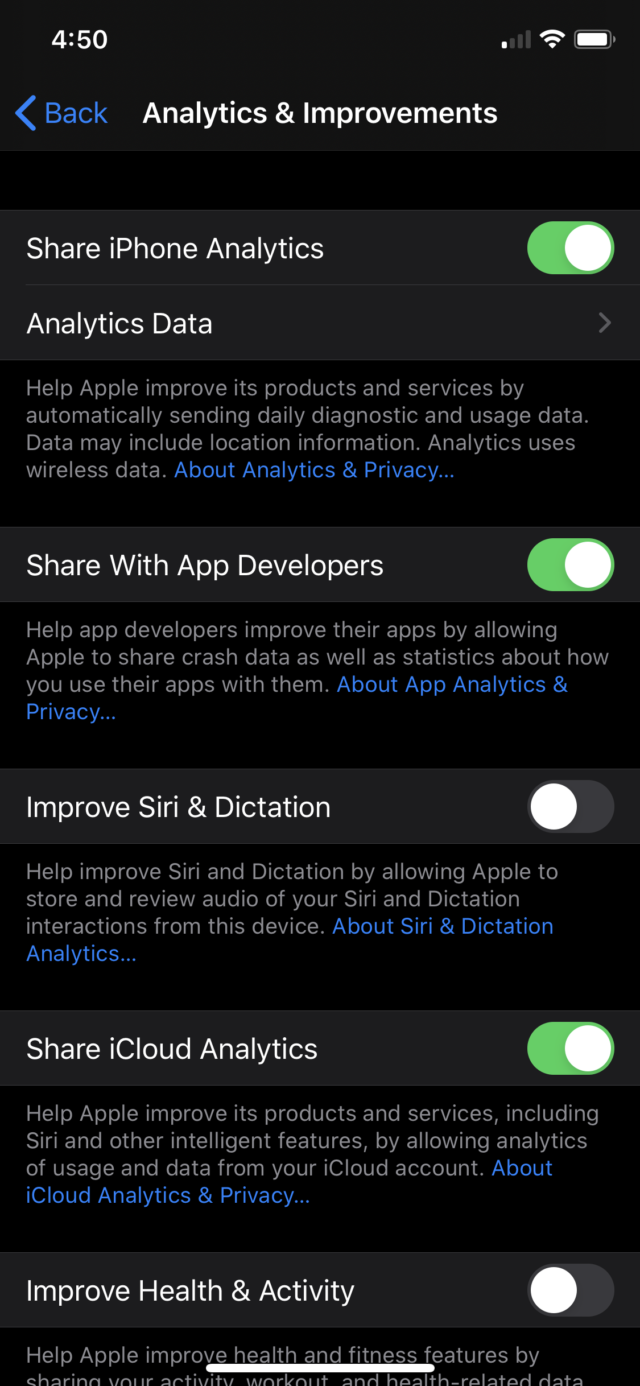

Generellt sett har vi två sätt att bygga modeller på. Det ena är där vi samlar in och märker data, vilket är lämpligt under många, många omständigheter. Och sedan finns det fall där vi ber användarna att donera sina data. Det mest anmärkningsvärda exemplet är Siri, där vi när du installerar en iPhone säger: ”Vill du hjälpa till att göra Siri bättre?”

Det är ett fall där en viss mängd data doneras till oss och där en mycket liten procentandel av dessa data kan användas för träning. Men många, många saker som vi talar om här – till exempel handskrift – kan vi samla in tillräckligt med data för att träna modellen så att den fungerar med i princip allas handstil utan att behöva använda några konsumentuppgifter alls.

Några av dessa uppmaningar om att använda dina uppgifter har lagts till nyligen. I somras visade en rapport att Siri spelade in vad användarna sa efter oavsiktliga aktiveringar; entreprenörer som hade till uppgift att kvalitetssäkra Siris funktionalitet hörde en del av dessa inspelningar.

Apple reagerade genom att åta sig att endast lagra Siri-relaterat ljud efter att användarna uttryckligen valde att göra Siri bättre genom att dela med sig av inspelningar (detta beteende infördes i iOS 13.2) och tog sedan all kvalitetssäkring in-house. Jag frågade vad Apple gör annorlunda än entreprenörerna gjorde med dessa data. Giannandrea svarade:

Vi har många skyddsåtgärder. Det finns till exempel en process för att identifiera om ljudet var avsett för assistenten eller inte, vilket är helt skilt från processen för att faktiskt granska ljudet. Så vi gör mycket internt för att se till att vi inte fångar – och sedan slänger – oavsiktligt ljud.

Men om du inte är villig att faktiskt kvalitetssäkra funktionen, så kommer du aldrig att göra de oavsiktliga inspelningarna bättre. Som du vet kräver maskininlärning att du ständigt förbättrar den. Så vi gjorde faktiskt en översyn av många av våra arbetsflöden och processer samtidigt som vi internaliserade arbetet. Jag är mycket övertygad om att vi har en av de allra bästa processerna för att förbättra assistenten på ett sätt som bevarar integriteten.

Det är tydligt att Apple försöker driva på integritetsskyddet som en nyckelfunktion i sina enheter; från Giannandrea framstod detta som en genuin övertygelse. Men det kan också hjälpa Apple på marknaden, eftersom dess största konkurrent inom mobilområdet har betydligt sämre resultat när det gäller integritetsskydd, och det lämnar en öppning när användarna blir mer och mer oroliga för konsekvenserna av artificiell intelligens för integritetsskyddet.

Under vårt samtal återkom både Giannandrea och Borchers till två punkter i Apples strategi: 1) det är mer effektivt att utföra maskininlärningsuppgifter lokalt och 2) det är mer ”integritetsbevarande” – ett specifikt ord som Giannandrea upprepade ett par gånger under samtalet – att göra det.

Inuti den svarta lådan

Efter att under lång tid mestadels ha arbetat med AI-funktioner i det fördolda har Apples betoning på maskininlärning ökat kraftigt under de senaste åren.

Företaget publicerar regelbundet, gör akademiska sponsringar, har stipendier, sponsrar labb, går på AI/ML-konferenser. Företaget lanserade nyligen en blogg om maskininlärning där det delar med sig av en del av sin forskning. Företaget har också anställt många ingenjörer och andra inom maskininlärning – inklusive Giannandrea själv för bara två år sedan.

Det leder inte forskarsamhället på samma sätt som Google, men Apple hävdar att det är ledande åtminstone när det gäller att ge fler användare tillgång till maskininlärningens frukter.

Minns du när Giannandrea sa att han var förvånad över att maskininlärning inte användes för handskrift med pennan? Han fortsatte med att se skapandet av det team som fick det att hända. Och tillsammans med andra team gick de vidare med maskininlärningsdriven handskrift – en hörnsten i iPadOS 14.

”Vi har många fantastiska maskininlärningsexperter på Apple, och vi fortsätter att anställa dem”, sa Gianandrea. ”Jag tycker att det är väldigt lätt att locka människor i världsklass till Apple eftersom det blir alltmer uppenbart i våra produkter att maskininlärning är avgörande för de upplevelser som vi vill skapa för användarna.”

Efter en kort paus tillade han: ”Jag antar att det största problemet jag har är att många av våra mest ambitiösa produkter är de som vi inte kan prata om, och därför är det lite av en försäljningsutmaning att säga till någon: ’Kom och jobba med den mest ambitiösa saken någonsin, men jag kan inte berätta vad det är.'”

Om man får tro de stora teknikföretagen och riskkapitalinvesteringarna kommer AI och maskininlärning bara att bli mer allestädes närvarande under de kommande åren. Hur det än kommer att gå, gjorde Giannandrea och Borchers en sak klart: maskininlärning spelar nu en roll i mycket av det Apple gör med sina produkter, och många av de funktioner som konsumenterna använder dagligen. Och i och med att Neural Engine kommer till Macs från och med i höst kommer maskininlärningens roll hos Apple troligen att fortsätta att växa.